「シャドーAI」とは?見えないAI利用が招く情報漏洩リスクと企業が今すぐ実施すべき対策

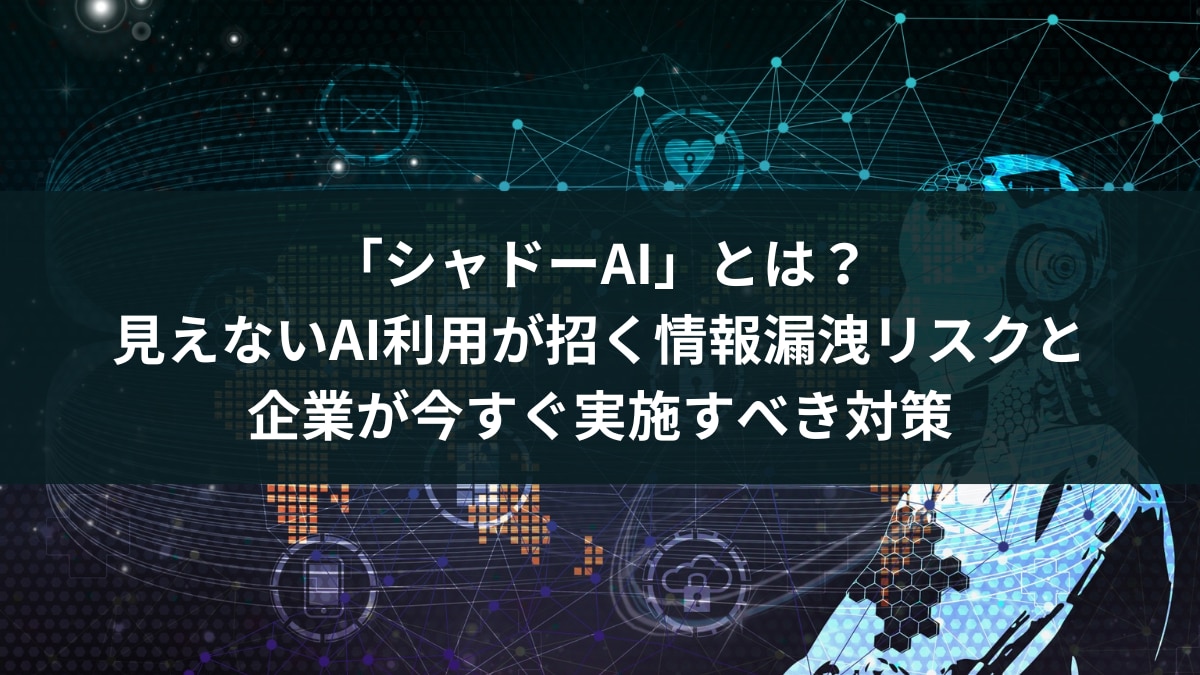

総務省「令和7年版 情報通信白書」が公表した調査結果によれば、日本国内の企業において生成AIの活用が拡大傾向にあることが確認されました。2024年度の調査では、生成AIの活用方針を定めている企業(「積極的に活用する方針」「活用する領域を限定して利用する方針」)の比率が49.7%となり、2023年度調査時の42.7%を上回りました。

総務省「国内外における最新の情報通信技術の研究開発及びデジタル活用の動向に関する調査研究」

を参考にエルテス作成

このことから、生成AIの急速な技術進展を背景に、多くの企業が業務効率化や戦略的な企業活動への応用を推進していることがわかります。

しかし急速な普及の一方で、従業員が生成AIに機密性の高いソースコードや会議記録を入力したことで情報が流出した事案も発生しており、新たなデジタルリスクが顕在化しています。中でも、企業が承認していない生成AIを従業員が個人的に業務に利用する「シャドーAI」のリスクも指摘されています。

このコラムでは、シャドーAIの定義から企業が今すぐ取るべき実践的な対策までを網羅的に解説します。

目次[非表示]

- 1.シャドーAIとは

- 2.「シャドーAI」と「シャドーIT」の違い

- 3.数字で見るシャドーAIの現状

- 4.シャドーAIが発生する背景

- 4.1.生成AIの利便性

- 4.2.企業の公式なAI導入やガイドライン策定の遅れ

- 4.3.従業員側のセキュリティリスク認識不足

- 5.シャドーAIが引き起こす企業リスク

- 5.1.機密情報・個人情報の漏洩リスク

- 5.2.コンプライアンス違反のリスク

- 5.3.企業セキュリティの脆弱化

- 6.企業が直面する具体的なリスクシナリオ

- 6.1.営業部門での情報漏洩リスク

- 6.2.人事部門での情報漏洩リスク

- 6.3.経営企画でのリスク事例

- 7.生成AIツール経由の機密情報漏洩事例

- 8.企業が今すぐ取るべきシャドーAI対策

- 8.1.従業員への教育

- 8.2.機密情報のアップロード・投稿の制限

- 8.3.適切な生成AIツールの導入と一元管理

- 8.4.ログ監視による不正利用の検知

- 9.シャドーAIを対策する内部脅威検知サービス(Internal Risk Intelligence)

- 10.まとめ

シャドーAIとは

シャドーAIとは、企業のIT部門や経営層が公式に許可・管理していないにもかかわらず、従業員が業務で独自に使用しているAIサービスやアプリケーションを指します。

具体的には、文章生成AIや画像生成AI、文字起こしツールなど、ブラウザ経由で手軽に利用できるツールが主な対象シャドーAIは、以前から問題視されてきた「シャドーIT」のAI版と位置づけられる概念ですが、AI性質上より複雑で深刻な問題を引き起こす可能性があり、AI技術の特性を踏まえたより高度なガバナンスとセキュリティ戦略が求められます。

「シャドーAI」と「シャドーIT」の違い

項目 | シャドーAI | シャドーIT |

具体例 | 業務データ、特に機密情報の生成AIツールへの入力 | 許可されていないITツールの利用 |

リスク | 入力したデータがAIの学習データとして使用される可能性がある | 許可されていないクラウドサービスなどへのデータ保存や、個人端末からの情報漏洩の可能性がある |

リスク分類 | 学習によるデータ漏洩など | セキュリティの脆弱性、不正アクセス、情報漏洩など |

シャドーAIとシャドーITの最も大きな違いは、従業員が機密情報をAIに入力して学習に使われてしまう可能性というデータ取り扱いにおけるリスクの深刻さにあります。

数字で見るシャドーAIの現状

AIベースのデータセキュリティを提供するアメリカのIT企業のCyberhaven, Inc.は、企業におけるAIツールの導入とデータ漏洩リスクに関する「2025 AI Adoption & Risk Report」を発表しました。

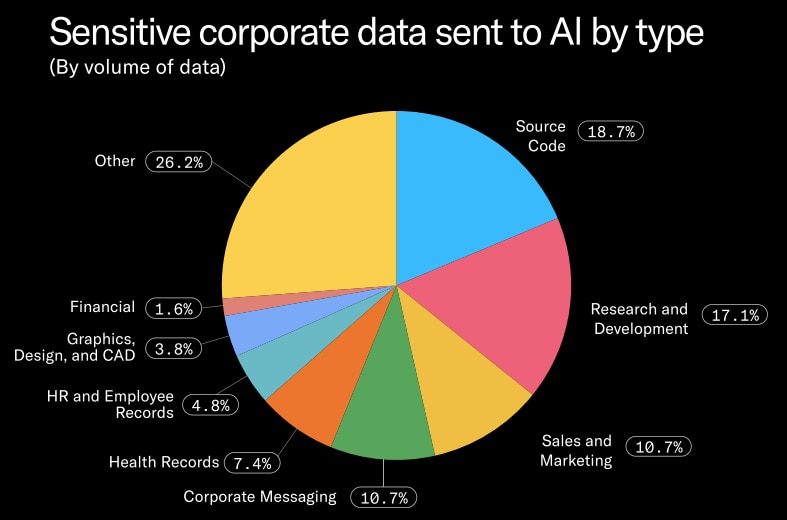

この調査結果によると、従業員がAIツールに入力される機密データとして最も多いのはソースコードで18.7%、次いで財務資料などの機密情報が17.1%を占めています。

引用:Cyberhaven Labs(2025)「2025 AI Adoption & Risk Report」

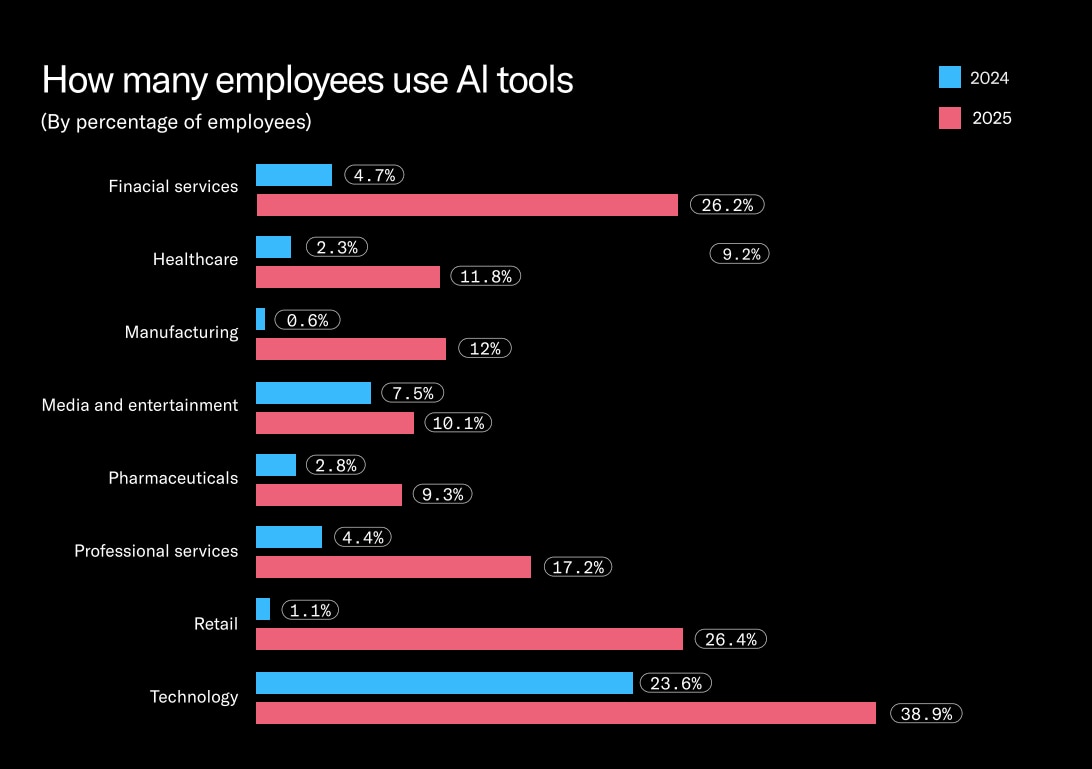

また、企業におけるAI使用頻度は過去1年で約4.6倍、過去2年間では約61倍と劇的に増加しています。特に、テクノロジー企業の従業員導入率は38.9%に上り、製造業や小売業でもそれぞれ20倍、24倍の成長率を示しました。

引用:Cyberhaven Labs(2025)「2025 AI Adoption & Risk Report」

この調査結果から、AIの利用が企業内で急速に広がるにつれて、機密データの意図しない外部流出リスクも比例して高まっていることがわかります。

シャドーAIが発生する背景

企業内でシャドーAIが発生し、情報漏洩リスクが高まる背景には、複数の要因が複雑に絡み合っています。

生成AIの利便性

ChatGPTのようなツールは、簡単な指示だけで質の高いアウトプットを瞬時に生成できるため、従来は数時間かかっていた資料作成や議事録作成、プログラミングコードの生成などの作業が数分で完了します。人員が限られ、成果が求められる環境において、従業員は業務負担の軽減と生産性を最大化するため、たとえ情報漏洩のリスクを認識していても、未承認のAIツールを利用してしまう場合があります。

企業の公式なAI導入やガイドライン策定の遅れ

企業がリスク評価やツール選定に時間を要する間に、従業員は自ら外部の解決策を探し始めます。また提供されていても機能が限定的であったり、利用申請が煩雑であったりすると、手軽な外部の無料サービスへ流れてしまう場合があります。

従業員側のセキュリティリスク認識不足

多くの従業員は、自身が入力した機密情報がAIモデルの学習に利用される可能性や、情報漏洩につながる危険性について十分に理解できていないのが実情です。便利なAIツールを「無料で利用できる」という感覚で安易に機密情報を入力してしまう場合があります。

シャドーAIが引き起こす企業リスク

次に、シャドーAIが企業にもたらす主要なリスクについて詳しく見ていきます。

機密情報・個人情報の漏洩リスク

シャドーAIが企業にもたらすリスクの中で、まず機密情報や個人情報の漏洩が挙げられます。従業員が未承認のAIツールに顧客情報、社内資料、開発中のプロダクト情報などを入力した場合、情報がサービス提供者のサーバーに保存され、他の利用者への回答に使用される可能性があります。特に無料版のAIサービスでは、利用規約でデータの学習利用が明記されているケースが多く見られます。

コンプライアンス違反のリスク

金融業界の「金融分野における個人情報保護に関するガイドライン」、医療業界の「HIPAA(Health Insurance Portability and Accountability Act;医療保険の携行性と責任に関する法律)」、製造業の「不正競争防止法」など、業界ごとに厳しいデータ管理規則があります。従業員がシャドーAIの利用規約を十分に確認せず、規制に反する形で業務にAIを利用した場合、企業は法的責任を問われる可能性があります。

企業セキュリティの脆弱化

シャドーAIは、企業全体のセキュリティ体制を脆弱にする危険性があります。未承認のAIツールは、IT部門のセキュリティポリシーや監視体制の対象外となるため、マルウェア感染やサイバー攻撃の対象として悪用されるリスクが高まります。

企業が直面する具体的なリスクシナリオ

シャドーAIが企業にもたらすリスクは多岐にわたりますが、抽象的な説明だけではその深刻さを十分に理解することは難しいかもしれません。

ここでは、企業の主要部門でシャドーAIがどのように利用され、どのような具体的な情報漏洩のリスクを引き起こし得るのかを、シナリオ形式で紹介します。

営業部門での情報漏洩リスク

営業部門では、業務効率化のために生成AIツールが使われやすいです。

たとえば、営業担当者が新しい見込み顧客へのアプローチメールを作成する際、「先月失注したA社の失敗要因は、価格と納期だった。今回はB社に同様の提案をするが、価格は10%抑えて、競合の動向も踏まえた返答例を作成してほしい」といった過去の商談情報、競合情報、今後の戦略に関する機密情報を入力するとします。

この情報は、外部のAIサービス提供者のサーバーに無防備な状態で保存される可能性があり、AIの学習データとして利用されるリスクが発生します。

人事部門での情報漏洩リスク

人事部門が機密性の高い採用情報や人員計画を扱う際にも、シャドーAIのリスクは潜んでいます。

人事担当者が「中途採用の面接質問例を作成してほしい」とAIに依頼する際、「現在のシステム開発チームは〇〇技術の経験者が不足しているので、そこを補える人材を探している」といった企業のウィークポイントに関する内部情報を、質問の背景情報として含めて入力したとします。

この情報が外部に漏洩すると、競合他社が自社の課題を容易に把握し、人材引き抜きや営業戦略に活用する可能性があります。

経営企画でのリスク事例

企業の将来を左右する極めて機密性の高い情報を扱う経営企画部門では、シャドーAIの利用が企業の存続につながるリスクがあります。

たとえば、「M&A候補企業の評価レポートを作成してほしい」とAIに依頼し、非公開の財務データや買収の法的リスク、交渉中の価格情報といった重要情報を入力したとします。

この機密情報が外部に流出すれば、競合他社に戦略立案のヒントを与えてしまったり、取引先との交渉で著しく不利な立場に追い込まれたりする事態を招きます。

生成AIツール経由の機密情報漏洩事例

シャドーAIによる情報漏洩は、すでに国内外で実際に発生し、企業に深刻な影響を与えています。例えば、韓国のある電子企業で、複数の従業員が機密情報をChatGPTに入力したことによる情報漏洩事件が発生しました。漏洩は少なくとも3件確認されています。

1件目: 半導体設備の測定データベース用ダウンロードソフトのエラー解決のため、ソースコードをChatGPTに入力。

2件目: 半導体の歩留まりや不良設備を把握するプログラムのソースコード最適化に、ChatGPTを利用。

3件目: 社内会議の音声データを文字起こしし、議事録作成のためにChatGPTに入力。

同社は社用デバイスや社内ネットワークでの生成AIシステムの利用を禁止する新たなポリシーを策定しました。さらに、個人端末でAIを利用する従業員に対しても、企業の知的財産や個人データにあたる情報を入力しないよう求め、違反者には解雇もあり得ると警告し、AIへの1回あたりのアップロード容量を制限し、従業員へのプライバシーリスク教育を徹底しました。

企業が今すぐ取るべきシャドーAI対策

ここまでシャドーAIの危険性について詳しく見てきました。対策として、単に利用を禁止するだけでは、現場の「業務効率化したい」というニーズに応えられず、かえって従業員が隠れて未承認のツールを使い続ける事態を助長してしまいます。

ここからは、正しいシャドーAIへの対策と情報漏洩リスクを低減するための具体的な施策を解説します。

従業員への教育

シャドーAI対策において最も重要な取り組みのひとつとなるのが、従業員への教育です。どんなに優れた技術的対策を講じても、従業員の意識が伴っていなければ限界があります。

課題を解決するためには、リスクが個人だけでなく会社全体に及ぶことを理解させる教育が欠かせません。具体的には、機密情報とは何か、どのようなAIツールの利用が危険か、著作権侵害のリスクは何かといった内容を、実際の業務に沿って具体例を交えながら、継続的に研修で伝えることが効果的です。

機密情報のアップロード・投稿の制限

技術的な側面からシャドーAIのリスクを軽減するためには、機密情報の外部AIサービスへのアップロードや投稿を制限する対策が効果的です。特に生成AIの利用においては、入力した情報が外部サーバーに学習・保存されるリスクがあるため、システムによる自動的な制御が不可欠となります。

DLP(Data Loss Prevention)などのセキュリティ技術を活用して、未承認の生成AIへの機密情報の入力やファイルのアップロードをブロックする対策が効果的です。

以下のコラムでは内部からの情報漏洩対策ソリューションを特徴や選定ポイントについて紹介しています。ぜひご覧ください。

適切な生成AIツールの導入と一元管理

現場の従業員が抱える「業務効率化」へのニーズに応えるには、企業としてセキュリティが担保された適切な生成AIツールを導入し、その利用を一元管理するアプローチが非常に重要です。具体的には、法人向けのセキュリティ機能が強化されたAIサービスを契約したり、自社専用のプライベート環境で動作するAIモデルを構築したりすることで、AIモデルの学習に利用されたりするリスクを最小限に抑えることができます。

ログ監視による不正利用の検知

シャドーAI対策の効果を高めるためには、従業員のAIツール利用状況を可視化し、不正利用を早期に発見するための「ログ監視」が不可欠です。ログを継続的に分析することで、どの部署の誰が、いつ、どのAIサービスを利用しているかを詳細に把握することが可能になります。

具体的には、アクセス元のIPアドレス、ユーザー名、アクセス日時、アクセス先のURLなどの情報を抽出し、未承認の生成AIサービスへのアクセスを定期的に確認します。異常なアクセスパターンや、普段利用しない外部サービスへの大量のデータ送信が検知できることで、従業員の利用実態を把握することができ、注意喚起を行ったり、場合によっては利用状況の詳細な調査に進んだりすることで、リスクが顕在化する前に対処できます。

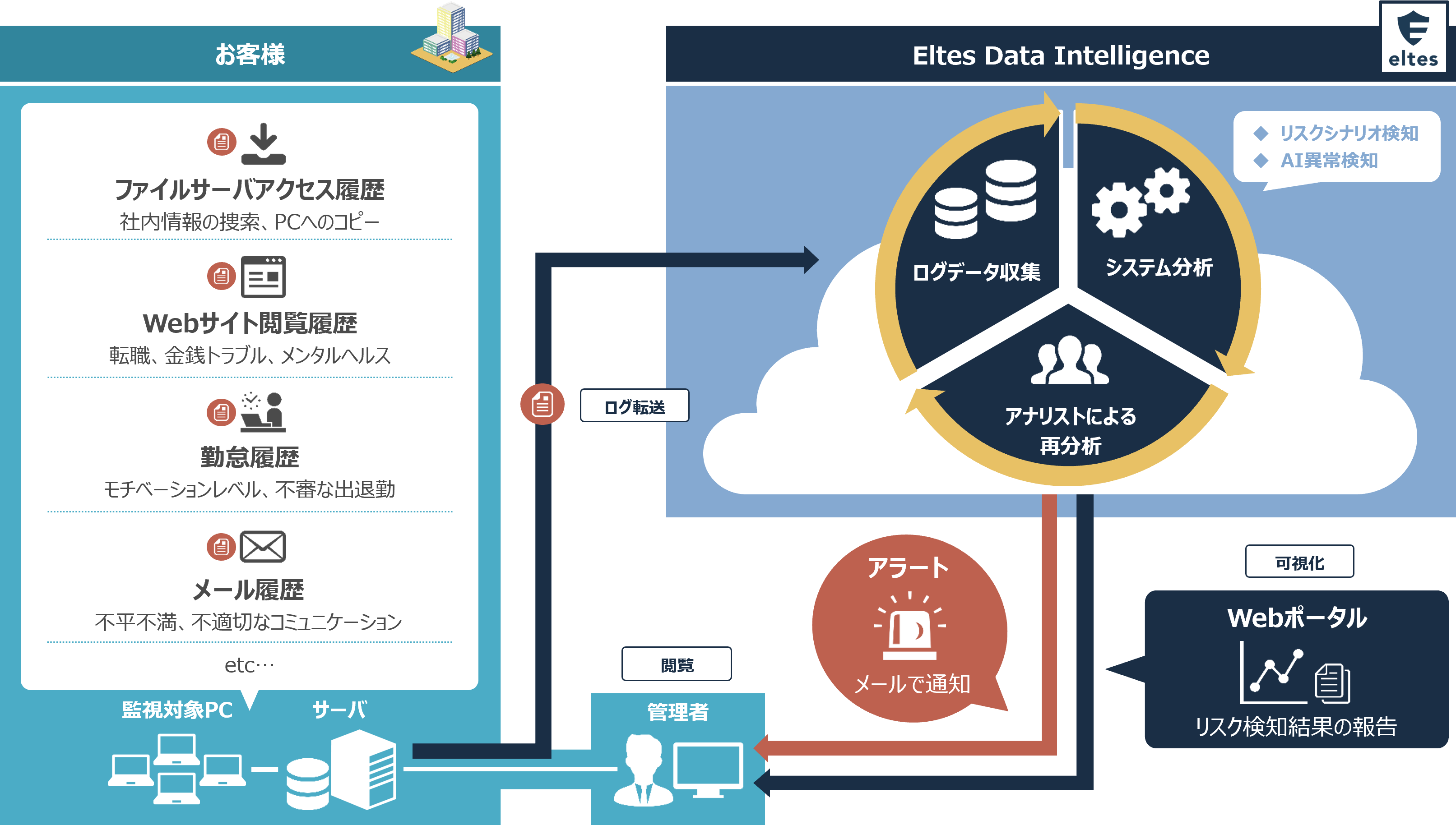

シャドーAIを対策する内部脅威検知サービス(Internal Risk Intelligence)

エルテスの内部脅威検知サービス(Internal Risk Intelligence)は、生成AIを介した内部脅威への対応を強化しています。具体的には、ChatGPTやGeminiなどへのWebアクセス履歴(アクセス先サービスやURL)や、生成AIへのWebファイルアップロード状況(アップロード先URL、ファイル名、保管場所)といった複数のログデータを複合的に分析することにより、リスク行為の可能性が高い場合にのみ、クライアントへ通知します。

また、安全な利用環境が整備されることで、生成AIの利用を禁止するのではなく、適切な活用の推進が可能となり、テクノロジーを活用した生産性向上とセキュリティを両立できる環境構築を支援します。

まとめ

生成AIは業務効率の向上や新しい価値創造の可能性をもたらす一方で、「シャドーAI」という未承認のAIツールの利用による新たな内部脅威を生み出しています。

シャドーAIへの対策は、単に特定のAIツールの利用を禁止するだけではなく、従業員のセキュリティ意識を高めるための継続的な教育、機密情報の外部送信を防ぐ技術的な制御、従業員が安全に利用できる企業が許可したAIツールの提供といった、多角的なアプローチが不可欠です。

情報セキュリティ体制や社内における生成AI活用におけるリスクについて相談がありましたら、ぜひエルテスへお問い合わせください。

シャドーAI対策のご相談は、エルテスへ